Неимоверный ажиотаж вокруг появления первой видеокарты GeForce GTX 1080 на новом графическом процессоре GP104 16-нм архитектуры Pascal компании NVIDIA ещё не успел стихнуть, а нынешний лидер 3D-графики уже выпускает следующую модель видеокарты – GeForce GTX 1070.

Она основана на том же чипе GP104, правда в несколько урезанном архитектурно виде, имеет чуть более низкие частоты графического процессора и обычную память GDDR5. Но благодаря более низкой стоимости и прогнозируемо высокому оверклокерскому потенциалу, именно GeForce GTX 1070 может стать наиболее популярной видеокартой среди любителей игр. Впрочем, обо всём по порядку.

Печатная плата

Печатная плата напоминает классический образец -вокруг чипа распаяны модули памяти, а подсистема питания отведена в правую часть. Все, включая чипы памяти и силовые элементы, охлаждается сплошной металлической пластиной, на которой расположен вентилятор.

Новый чип (GP104-400-A1) получился весьма экономичным и не требует повышенного внимания при отводе тепла. Первое, что бросается в глаза, так это отсутствие металлической рамки вокруг GPU, которая могла бы защищать кристалл от сколов. Модули памяти типа GDDR5X набраны 8 микросхемами производства Micron. Подсистема питания графического процессора насчитывает пять фаз, еще одна фаза отведена на память. В качестве транзисторов используются NTMFD4C85N производства ON Semiconductor.

Обратная часть платы лишена каких-либо значимых элементов. Все чипы памяти распаяны с лицевой стороны.

Однако, если присмотреться, то здесь можно обнаружить ШИМ-контроллер uP9511Pпроизводства UPI, который управляет питанием.

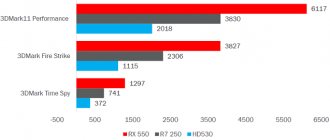

Результаты замеров FPS в играх

Тестирование видеокарты проводятся при разрешении 3840×2160, настройки графики – максимальные.

| Игра | Кадры в секунду |

| Assassin’s Creed Syndicate | 63 |

| Battlefield 1 | 66 |

| Dishonored 2 | 58 |

| Far Cry Primal | 51 |

| GTA V | 75 |

| Crysis 3 | 70 |

| Tom Clancy’s The Division | 57 |

Тесты GTX 1080 Ti в играх показали, что видеоадаптер способен обеспечить высокую производительность в любой современной игре при максимальных настройках изображения.

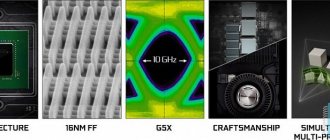

Что новенького?

По утверждениям компании NVIDIA, новая архитектура является революционной, но так ли это на самом деле? Наиболее ярким нововведением в случае сPASCAL является переход на новый техпроцесс 16-нм и использование видеопамяти нового типаGDDR5X. Все это позволило добиться значительного прироста рабочей частоты GPU и пропускной способности памяти, что привело к заметному росту производительности. Еще одной важной особенностью стало применениеFinFET(Field Effect Transistor with Fin) – транзисторов, благодаря чему произошло снижение энергопотребления и повышение эффективности. Несмотря на это, архитектура PASCAL представляет собой скорее эволюцию Maxwell, чем что-то принципиальное новое.

Интересные нововведения коснулись и SLI. Теперь компания станет уделять больше внимания тандему из двух ускорителей, т.е. постарается максимально оптимизировать масштабирование производительности именно для подобного сценария. Однако это не означает, что использование трех или даже четырех видеокарт теперь станет невозможным, отнюдь нет, просто акцент будет смещён в сторону наиболее востребованного варианта. Ни для кого не секрет, что позволить себе систему из трех или четырех видеокарт могут лишь единицы.

Для любителей многомониторных конфигураций и шлемов виртуальной реальности NVIDIA заготовила технологию единовременного мультипроецирования (Simultaneous Multi-Projection). По сути это оптимизация призвана осуществлять одновременный просчёт геометрических данных для нескольких заранее заготовленных проекций. Для чего это нужно? Во-первых, для устранения различных искажений при использовании изогнутых мониторов или конфигураций с несколькими дисплеями. Во-вторых, это позволяет повысить производительность для подобных сценариев использования вашей системы. Немногие из нас имели возможность опробовать в своё время NVIDIA 3D Vision, но те кому довелось, отмечали заметную нехватку производительности, так как на видеокарту ложилась двойная нагрузка при прорисовке изображений для каждого глаза. С внедрением SMP эта проблема устраняется.

Также, нельзя не упомянуть еще о двух интересных новшествах, которые озаглавлены как Ansel и Fast Sync:

Ansel – бесценный инструмент для создания сопутствующего игрового контента, что пригодится стримерам и авторам различных игровых блогов. В процессе игры вы можете нажать на паузу и отрегулировать камеру под любым требуемым углом для создания скриншота. Помимо этого вам будет доступен ряд эффектов для улучшения изображение, а также возможность сделать снимок с потрясающей четкостью. Помимо этого существует возможность создания 3D изображения, панорамных скриншотов и 360° снимков. Правда следует оговориться, что доступно это будет только в тех играх, где будет введена соответствующая поддержка данной опции.

Fast Sync – это своеобразное дополнение к такой функции, как VSYNC. В общих чертахактивация этого нововведения позволит вам избавиться от задержек, что происходит при включении VSYNC. Помимо этого устраняются артефакты в виде разрыва картинки, что может быть заметно при отключении вертикальной синхронизации. Данный сценарий справедлив только в том случае, если значение FPS превышает порог частоты обновления экрана.

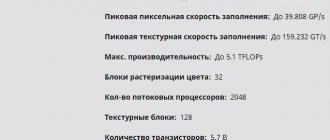

Технические характеристики

Как и TITAN X, GTX 1080 Ti основана на графическом процессоре GP102. Из-за этого их характеристики схожие, но объем памяти у новинки снижен из 12 до 11 Гб. Причина этого кроется в урезанной шине памяти в 352 бита вместо 384. Небольшая разница в количестве видеопамяти компенсируется ее повышенной частотой. Основные характеристики Geforce GTX 1080 Ti представлены в таблице ниже.

| Технический процесс, нм | 16 |

| Количество транизисторов, млрд | 12 |

| Частота памяти, Мгц | 11408 |

| Частота ядра, Мгц | 1480 |

| Тип видеопамяти | DDR5X |

| Объем видеопамяти, Гб | 11 |

| Шина памяти, бит | 352 |

| Энергопотребление, Вт | 250 |

| Максимальная температура, С | 91 |

| Пропускная способность памяти, ГБ/c | 484 |

Впечатляющие характеристики нового видеоадаптера существенным образом сказываются на ее цене. Сразу после выхода цена составляла порядка 800 долларов. Но в связи с существенным ростом популярности криптовалюты и прибыльности ее майнинга, спрос на видеоадаптер вырос в разы. Соответственно и цена тоже. Теперь купить ее можно примерно за 1100 долларов.

Сколько ватт нужно для 3070?

Заявленное энергопотребление видеокарты составляет 220 Ватт

, что выливается в официальные рекомендации к мощности блока питания от 650

Ватт

. RTX

3070

Founders Edition получила фирменный 12-pin разъем для питания. В комплекте с видеокартой идет необходимый кабель-переходник 12-pin to 8-pin.

Интересные материалы:

Как правильно установить время на компьютере? Как правильно установить WhatsApp на планшет? Как правильно установить защитное стекло на планшет? Как разрешить установку APK? Как разрешить установку из неизвестных источников андроид 10? Как разрешить установку из неизвестных источников IOS? Как разрешить установку из неизвестных источников виндовс 10? Как самому установить Виндовс 10? Как снять запрет на установку программ андроид? Как сохранить данные перед сбросом на заводские установки?

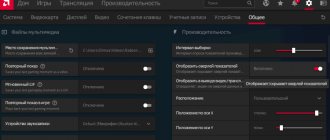

Разгон

Во время экспериментов с разгоном стоит изначально увеличить допустимый лимит мощности. Адаптер позволяет повысить Power Limit до 120%. Базовую частоту графического процессора удалось увеличить до 1642 МГц.

После разгона графический процессор под реальной игровой нагрузкой ускорялся до 1923–1974 МГц. Утилиты мониторинга фиксируют пиковые 2075 МГц, но это лишь единичные всплески.

Фактическая рабочая частота GP102 вплотную подобралась к 2000 МГц. При этом стабильно превысить этот символичный порог не позволяет механизм динамического авторазгона. При повышении тактовой частоты GPU увеличивается как энергопотребление, так и нагрев чипа. Согласно алгоритму, видеокарта старается удержать температуру графического процессора в заданных пределах. После разгона чип прогревается до 85 градусов, при этом скорость вращения вентилятора превысила 3000 об/мин.

Несмотря на то, что формально базовая частота GPU была увеличена на 10,9%, фактические значения рабочих частот будет ниже. GPU Boost приходится контролировать нагрев чипа и его энергопотребление, не позволяя ускориться сверх нормы.

Микросхемы памяти также удалось дополнительно ускорить. Чипы стабильно работали на эффективных 12112 МГц (+10%).

Позиционирование

Прежде чем приступить к ознакомлению с видеокартой необходимо определиться с портретом потенциального покупателя. На кого рассчитана GTX 1080 в первую очередь? Прежде всего на тех, кто не готов идти на компромисс и хочет насладиться в полной мере играми на WQXGA или UHD мониторах. Также, новинка придётся в пору продвинутым стримерам, энтузиастам, оверклокерам и прочему контингенту, который все же отличается от массового потребителя и точно знает, чего хочет. При этом, с учетом текущей цены в 55-60 тысяч рублей круг будущих владельцев сужается еще больше и говорить о «народной карте» здесь попросту не уместно. Увы и ах, несмотря на столь впечатляющую производительность и приятный бонус в качестве разгона в нашей стране позволить себе такой графический ускоритель смогут лишь немногие.

Система охлаждения

Референсный дизайн системы охлаждения не претерпел каких-либо значительных изменений. Это по-прежнему система охлаждения турбинного типа, которая позволяет выбрасывать горячий воздух за пределы системного блока. Такой тип конструкции оправдывает себя при использовании в компактных системах, а также подходит при построении системы на базе нескольких графических ускорителей.

Основной радиатор отводит тепло только от графического чипа. В его основе лежит принцип испарительной камеры. Роль активной части СО выполняет цилиндрический вентилятор, который снабжён рядом оптимизаций для снижения уровня шума.

Видеокарты с альтернативной системой охлаждения частенько экономят на бэкплейт, что вкупе с нестандартным цветом печатной платы выглядит не всегда так, как хотелось бы. Особенно если вы стараетесь собрать аккуратную сборку с соблюдением цветовой схемы. Однако, в случае с Founders Edition об этом можноне беспокоиться. Бэкплейт разделён на две равнозначные части и по сути не участвует в процессе охлаждения, здесь он играет роль ребра жёсткости.

Блок питания для GEFORCE GTX 1070 и GTX 1070 Ti

Для того чтобы узнать, какой блок питания подойдет для видеокарты NVIDIA GEFORCE GTX 1070 и GTX 1070 Ti нам нужно изучить характеристики на сайте компании NVIDIA. Согласно официальным характеристикам, данная видеокарта потребляет 150-180 Вт мощности. При чем этот показатель одинаковый, как для обычной версии, так и для улучшенной версии с приставкой Ti.

Также в характеристиках видеокарты компания NVIDIA дает рекомендации по мощности блока питания. В этом случае для обоих версий GTX 1070 рекомендуемая мощность БП составляет 500 Вт.

Проверить рекомендуемую мощность блока питания, которую указала NVIDIA, можно при помощи онлайн калькулятора БП. Данные калькуляторы позволяют примерно оценить мощность блока питания на основе используемых комплектующих. В нашем случае мы будем пользоваться калькулятором от MSI. Мы укажем процессор Intel Core i9 9900KF, одну видеокарту GEFORCE GTX 1070 Ti, 2 жестких диска, 4 модуля оперативной памяти, 4 вентилятора, 4 дополнительных карты PCI express и 1 DVD-привод. С такими комплектующими калькулятор от MSI рекомендует чуть больше 450 Вт.

В данном случае калькулятор от MSI выдал результат на 50 Вт меньше, чем рекомендует NVIDIA. Поэтому, для максимальной надежности нужно ориентироваться на большее значение.

Таким образом можно сделать вывод, что для штатной работы видеокарты NVIDIA GEFORCE GTX 1070 или 1070 Ti нужен блок питания мощностью 500 Вт. Если вы хотите оставить место для апгрейда или просто хотите перестраховаться, то вы можете установить БП с некоторым запасом. Например, можно приобрести модель, которая выдаст на 100 Вт больше. Таким образом, для GTX 1070 и GTX 1070 Ti мощность БП с запасом будет составлять 600 Вт.

⇡#Температура и энергопотребление

Как правило, во всех наших тестах температура графических процессоров AMD оказывается ниже, чем температура GPU равноценных ускорителей NVIDIA, в случае, если установлена эталонная система охлаждения. В данном случае ситуация иная. В офисном режиме температура графического процессора GeForce GTX 580 находится на одном уровне с GPU Radeon HD 5870, в игровом режиме GF110 оказывается всего на 4 градуса горячее, что очень даже неплохо, поскольку менее производительный GF100 в аналогичных условиях прогревался до 94 градусов Цельсия!

Для получения подобного результата, как мы уже говорили выше, инженеры NVIDIA не только использовали новую систему охлаждения, принцип работы которой идентичен принципу работы СО Radeon HD 5970, но и провели серьёзную “транзисторную” модернизацию GPU. Обратим ваше внимание, что на протяжении всего процесса тестирования шум системы охлаждения GeForce GTX 580 не выделялся на фоне шума остальных компонентов системы. С нашей точки зрения это очень хороший результат, особенно учитывая прошлые “заслуги” NVIDIA в плане нагрева GPU и уровня шума стандартных систем охлаждения. Посмотрим, как обстоят дела с аппетитом GTX 580.

В типичных режимах с энергопотреблением у GeForce GTX 580 тоже наблюдается полный порядок. Да, Radeon HD 5870 по-прежнему экономичнее, однако разница между GTX 580 и HD 5870 настолько незначительна, что в данном случае можно засчитать ничью.

В отличие от GeForce GTX 480, который хоть и опережает Radeon HD 5870, но делает это не очень уверенно, ускоритель GeForce GTX 580 отрывается от конкурента достаточно заметно. Более того, даже без разгона GeForce GTX 580 находится в опасной близости от флагмана компании AMD – ускорителя Radeon HD 5970.

Как мы уже неоднократно отмечали, архитектура GF100 (а значит и GF110) оптимизирована для работы в сверхтяжёлых режимах. В режимах без сглаживания с существенным отрывом от всех прочих ускорителей идёт Radeon HD 5970, но как только включается полноэкранное сглаживание, двухчиповый флагман AMD начинает сдавать позиции, не сильно опережая неразогнанный ускоритель GeForce GTX 580 в разрешении 1680×1050 и отставая от него при работе с разрешением 1920×1200.

Как известно, гоночный симулятор Colin McRae DiRT 2 стал одной из первых игр, поддерживающих DirectX 11 и тесселляцию, использование которой в этой игре видно далеко не всегда, а в процессе гонки эффект от неё и вовсе с трудом различим. Тем не менее, даже несмотря на невысокую степень тесселляции, GeForce GTX 580 выглядит очень уверенно, обгоняя даже Radeon HD 5970 вне зависимости от выбранного режима. Безусловно, даже в самом тяжёлом режиме DiRT 2 прекрасно работает на Radeon HD 5870, и уж тем более на Radeon HD 5970, однако счётчик кадров упрямо показывает перевес представителей зелёного лагеря, в этом тесте GeForce GTX 580 одерживает убедительную победу. Посмотрим, что будет дальше.

Культовый Crysis, ставший на несколько лет вперёд чуть ли не эталоном с точки зрения графики. До сих пор по качеству картинки этот проект может без особого труда соперничать со многими играми, вышедшими в этом году. В данном случае GeForce GTX 580 уступает старшему ускорителю на базе GPU Cypress и лишь незначительно опережает одночиповый Radeon HD 5870.

Превосходство ускорителя GeForce GTX 580 над своим предшественником GeForce GTX 480 составляет порядка 15%, однако этого оказывается вполне достаточно для того, чтобы даже без разгона обойти Radeon HD 5970! Отличный результат.

В игре Just Cause 2 новый флагман NVIDIA опережает GeForce GTX 480 примерно на 10-15%, в зависимости от используемого графического режима, в данном случае такого перевеса хватает лишь для того, чтобы соперничать с Radeon HD 5870, в то время как HD 5970 вне досягаемости.

Ускоритель GeForce GTX 580 в игре Alien versus Predator легко кладёт на лопатки Radeon HD 5870 даже в относительно “простых” режимах без сглаживания и анизотропной фильтрации, но даже после разгона флагман NVIDIA не сумел догнать и уж тем более перегнать Radeon HD 5970.

Официальный бенчмарк Final Fantasy XIV не лучшим образом относится к многочиповым решениям и, судя по результатам, игнорирует второй GPU Radeon HD 5970. Стоит помнить, что тактовые частоты флагманского ускорителя AMD снижены относительно значений установленных для Radeon HD 5870 — именно это и объясняет проигрыш Radeon HD 5970 более дешёвому решению AMD. Что же касается продуктов NVIDIA, то, в разрешении 1280×720 результаты, судя по всему, ограничиваются мощностью центрального процессора, который не в состоянии “прокачать” данными не только GeForce GTX 480, но уж тем более GeForce GTX 580. В результате, в низком разрешении лидирует Radeon HD 5870, а в разрешении 1920×1080 победа достаётся GTX 580, который после разгона прибавил очень мало баллов. Возможно, это вновь связано с недостаточной производительностью центрального процессора.

В игре Metro 2033 разработчики уделили много внимания проработке деталей виртуального мира. Даже кабели на стенах выполнены в виде полноценных 3D-моделей, а не текстур, как это было раньше. Движок Metro 2033 очень требователен к ресурсам GPU, особенно по части скорости обработки геометрии и тесселляции. В лёгких режимах Radeon HD 5970 совсем незначительно опережает GeForce GTX 580, зато с переходом к супертяжёлым режимам, новинка от NVIDIA выглядит более предпочтительно, чем HD 5970. Более того, даже GTX 480 проявляет себя, показывая лучший результат, чем Radeon HD 5970.

Движок Lost Planet 2 показывает аналогичную картину. Ускоритель Radeon HD 5970 оказывается несколько быстрее, чем GeForce GTX 480 или выступает с ним на равных. А вот главный герой нашего обзора — GeForce GTX 580, в этом тесте опережает всех представителей красного лагеря.

Тестовый пакет Unigine Heaven 2.0 – одно из немногих приложений, способных передать всю красоту сложного режима тесселляции. Чтобы понять, о чём идёт речь, ознакомьтесь с отдельным материалом, посвящённом тесселляции. Итак, уже давно было отмечено, что одним из слабых мест в архитектуре GPU Cypress является недостаточно мощный блок тесселляции. Это наглядно демонстрируют графики, из которых видно, что даже Radeon HD 5970 оказывается слабее GeForce GTX 480, причём разница в результатах весьма существенная. Для современных флагманских GPU Cypress от AMD ситуация уже вряд ли изменится, а вот будущие GPU с кодовым именем Cayman должны получить куда более мощные блоки тесселляции и верится в это охотно, судя по тому, как прибавила в скорости средняя по стоимости видеокарта AMD Radeon HD 6870.

Не успел аркадный симулятор HAWX 2 попасть на прилавки магазинов, как бенчмарк из этой игры, вышедший как раз в день анонса Radeon HD 6850/6870, успел наделать много шума. Причиной волнений послужил выход недоработанной бета-версии тестового пакета HAWX 2. В этом многие тут же увидели попытки NVIDIA ослабить интерес публики к Radeon HD 6850/6870. Мы не будем судить за это компанию NVIDIA, тем более что на данный момент вышла полная версия бенчмарка HAWX 2, где режим DirectX 11, как и тесселляция, работает — самое время пройти тестирование. К сожалению, даже самый быстрый ускоритель AMD уступает пальму первенства GTX 580, причём разница почти двукратная. Насколько нам известно, AMD готовит ряд поправок для своих драйверов, с целью минимизировать отставание в этом тесте от GPU NVIDIA.

В качестве небольшого дополнения отметим, что результаты работы тесселляции в этой игре заметны невооружённым глазом. Ниже мы приведём скриншотов, взятых из официальной презентации NVIDIA. На них чётко видны отличия в качестве прорисовки рельефа.

Первое, что бросается в глаза при просмотре результатов тестирования в игре Mafia II, так это мизерный отрыв Radeon HD 5970 от Radeon HD 5870. Безусловно, двукратного и даже близкого к двукратному отрыва Radeon HD 5970 от младшего собрата не будет, тем не менее, 10% разницы – это слишком мало. Переустановка драйверов, к сожалению, не принесла результата, остаётся надеяться на будущие версии драйверов. Ну, а пока ускорители Radeon HD 5870 и Radeon HD 5970 в игре Mafia II способны тягаться лишь с GeForce GTX 480, где-то выигрывая, где-то уступая бывшему королю среди решений NVIDIA. Особнячком, если так можно выразиться, стоит GeForce GTX 580, которому, по большому счёту, для победы над конкурентами разгон не нужен.