Разгон видеокарты и связанные с ним риски

Разгон видеокарты — это изменение некоторых штатных параметров ее работы, вследствие чего увеличивается ее производительность (в среднем на 5-20%). Во многих случаях разгон

позволяет пользователю комфортно играть в компьютерные игры, которые на стандартных настройках его видеокарта не «вытягивает». Следовательно, благодаря разгону можно сэкономить денег, отложив или вообще отказавшись от приобретения более производительной видеокарты. Но не все так просто, как кажется на первый взгляд. Есть у этого всего и обратная сторона. Дело в том, что видеокарта в разогнанном состоянии более подвержена вероятности выхода из строя. Приступая к разгону, вы должны четко осознавать, что своими действиями вы можете повредить аппаратную часть компьютера. Прибегать к разгону следует, если ради увеличения производительности видеокарты вы готовы рискнуть. С другой стороны, если к

разгону

подойти с умом и не пытаться выжать из видеокарты слишком много, этот риск становится не значительным. Необходимо учитывать, что при разгоне увеличивается мощность электроэнергии, потребляемая видеокартой. Перед разгоном желательно убедиться, что сила тока блока питания по линии +12В с запасом превышает потребности видеокарты. В противном случае блок питания может стать причиной нестабильной работы компьютера. Об оценке соответствия блока питания требованиям компьютера читайте здесь. В статье рассматривается один из способов

разгона видеокарт серии GeForce

. Чтобы сделать статью более наглядной, автор построил ее в форме описания разгона «подопытной» видеокарты GeForce GTS 450. Аналогичным образом можно разгонять любую карту от nVidia GeForce. Ниже расположены изображения с описанием всех необходимых действий. Если у вас графический адаптер от ATI (Radeon), читать статью смысла нет.

Чтобы разогнать видеокарту

пользователю нужно увеличить следующие параметры ее работы: • частота графического ядра; • частота памяти; • частота шейдерных блоков. Для обеспечения стабильности работы с новыми параметрами придется также немного повысить напряжение питания видеокарты. Углубляться в описание указанных параметров не будем. Кому интересно — читайте о них здесь.

Как разогнать карту AMD

Разгон видеокарты AMD можно осуществить с помощью стандартных средств, которые находятся в пакете драйверов OverDrive или WattMan.

Для начала необходимо обновить драйвер AMD, так как последняя версия программного обеспечения подразумевает более стабильную работу оборудования. В качестве программы для тестирования возможностей видеоадаптера рекомендуется использовать бенчмарки 3DMark или FurMark.

Процесс разгона осуществляется следующим образом:

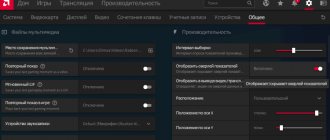

- Заходим в «Настройки Radeon», «Игры».

- Открываем «Глобальные настройки» и переходим во вкладку «Глобальный Wattman» (или «OverDrive», в зависимости от установленных драйверов).

- Для начала необходимо повысить энергопотребление графического адаптера. Сделать это можно в разделе «Ограниченное энергопотребление», передвинув ползунок в правую сторону на несколько делений. После этого сохраняем изменения.

- Затем начинается долгий процесс постепенного увеличения частот ядра и видеопамяти. Сохранив изменения, запускаем программу 3DMark или FurMark и начинаем тестирование карты.

- При появлении на экране артефактов в виде зависаний, миганий и других признаков нестабильной работы отменяем тест. Уменьшаем частоту и проводим те же самые операции до тех пор, пока не будут найдены оптимальные настройки для разгона.

При желании можно также осуществить разгон монитора. В настройках нужно открыть раздел «Дисплей» и создать новое пользовательское разрешение. В пункте «Частота обновления экрана» необходимо постепенно поднимать число Гц.

MSI Afterburner – еще одна программа для разгона видеокарты AMD, которая позволит осуществить процесс увеличения производительности более точнее, используя дополнительные параметры.

Разгон видеокарты GeForce

Перед началом разгона

необходимо узнать показатели указанных выше параметров видеокарты в обычном состоянии. С этой целью можно использовать бесплатную утилиту

GPU-Z

. После установки и запуска утилита GPU-Z покажет подробную информацию о видеокарте компьютера, в том числе и необходимые нам данные.

На изображении видно, что подопытная GeForce GTS 450 в штатном режиме имеет следующие параметры (обведены красным): • частота графического ядра (GPU Clock) — 783 MHz; • частота шейдерных блоков (Shader) — 1566 MHz; • частота памяти видеокарты (Memory) — 902 MHz (1804). Обратите также внимание на то, что с такими параметрами видеокарта GeForce GTS 450 демонстрирует следующую продуктивность (обведены зеленым): • PixelFillrate — 6,3 GPixel/s • TextureFillrate — 25,1 GTexel/s • пропускная способность памяти (bandwidth) — 57,7 GB/s. Для изменения указанных параметров будем использовать бесплатную программу

nVidia Inspektor

. Программа nVidia Inspektor не требует установки. После загрузки просто запускаем ее. Откроется окно, в нижнем правом углу которого находится кнопка с названием «Show Overclocking». На нее нужно нажать мышкой и в следующем диалоговом окне подтвердить открытие дополнительных параметров (нажать кнопку «Да»). После этого откроется панель

разгона видеокарты

(см. изображение).

Сначала поднимем значение частоты ядра (GPU Clock) и частоты шейдерных блоков (Shader Clock). Эти параметры взаимосвязаны. Поэтому повышение частоты шейдерных блоков автоматически повлечет за собой рост частоты графического ядра. Для повышения необходимо ползунок Shader Clock передвинуть вправо. Увеличивать частоту больше чем на 15% от исходной не рекомендую. Если для нашей GeForce GTS 450 поднять Shader Clock на 15 % от исходных (1566 MHz), получится где-то около 1800 MHz. В случаях с другими видеокартами показатели, естественно, будут другими. Увеличив Shader Clock можно увидеть, что вслед за ней увеличится и частота графического ядра. Для GeForce GTS 450 Shader Clock был увеличен до 1800 MHz, частота графического ядра автоматически поднялась до 900 MHz (см. скриншот). Чтобы изменения вступили в силу, необходимо нажать кнопку «Apply Clock&Voltage».

Перед тем, как переходить к повышению частоты памяти видеокарты, необходимо убедиться в стабильности ее работы с новыми параметрами ядра и шейдерных блоков. С этой целью видеокарту нужно протестировать на выполнении какой-то задачи, связанной с обработкой графических данных. Прекрасным тестом стабильности является бесплатная программа

FurMark

. Для проверки видеокарты устанавливаем и запускаем FurMark. В окне программы жмем кнопку «BURN-IN test» и наблюдаем за картинкой («вращающийся волосатый бублик», см. изображение). Если в течение продолжительного времени (не менее 10-15 мин.) на изображении не будет появляться никаких артефактов (мерцание, точки, мигание и другие признаки нестабильности), значит видеокарта с новыми параметрами работает нормально. Кроме того, во время тестирования FurMark необходимо следить за температурой видеокарты. График температуры отображается в нижней части окна FurMark. Температура не должна превысить 90 градусов С. Если появятся артефакты или температура станет слишком высокой, необходимо остановить тест (нажав кнопку Escape), немного снизить частоту видеоядра и шейдерных блоков (в программе nVidia Inspektor) и затем повторить тестирование.

Когда будет найдена оптимальная частота для ядра и шейдерных блоков, можно продолжить разгон видеокарты. Возвращаемся в окно программы nVidia Inspektor и таким же способом увеличиваем частоту памяти видеокарты (передвигаем вправо ползунок Memory Clock). После изменения параметров для вступления их в силу не забудьте нажать кнопку «Apply Clock&Voltage».Стабильность работы

видеокарты с разогнанной памятью

также необходимо проверить при помощи теста FurMark. Если появятся артефакты, частоту памяти нужно снижать до достижения стабильности. В случае с нашей подопытной GeForce GTS 450 частота памяти была увеличена на 15 % с 1804 MHz до 2075 MHz. Определение максимальных рабочих частот для видеоядра, шейдерных блоков и памяти — это самый длительный и сложный этап разгона. После его завершения останется только немного поднять напряжение питания видеокарты чтобы обеспечить более высокую стабильность ее работы. С этой целью в окне программы nVidia Inspektor нужно немного (на 1 «шажок») сдвинуть вправо ползунок «Voltage». Для GeForce GTS 450 напряжение было увеличено с 1,075 V до 1,125 V. Для вступления изменений в силу не забываем нажать кнопку «Apply Clock&Voltage» (см. изображение выше).Новые настройки видеокарты программа nVidia Inspektor позволяет сохранить в отдельный файл. В дальнейшем для того, чтобы быстро перевести видеокарту из обычного состояния в разогнанное, достаточно будет просто запустить этот файл. Создадим такой файл для осуществленных нами настроек. Для этого в окне программы необходимо нажать кнопку «Creat Clocks Chortcut». Файл с настройками будет создан на рабочем столе компьютера.

Если вы хотите, чтобы ваша видеокарта автоматически разгонялась при включении компьютера

, нужно добавить этот файл в папку с названием «Автозагрузка». Windows во время запуска открывает все файлы, находящиеся в этой папке, благодаря чему видеокарта будет автоматически разгоняться при включении компьютера.

В Windows XP, Vista, 7 папка «Автозагрузка» расположена в меню «Пуск». Нужно найти ее там, щелкнуть по ней правой кнопкой мышки и в появившемся меню выбрать «Открыть».

В Windows 8 и Windows 10 открыть папку «Автозагрузка» немного сложнее. Подробные рекомендации по этому вопросу расположены здесь.

Видеокарту также можно разогнать «навсегда», то есть, сделать так, чтобы она постоянно работала на повышенных частотах графического ядра и видеопамяти без использования nVidia Inspektor или какой-то другой программы. С этой целью подходящие для нее повышенные частоты, которые были определены описанным выше способом, необходимо прошить в ее BIOS. Инструкция по перепрошивке BIOS видеокарты размещена здесь.

Zotac Firestorm

Эту утилиту компания Zotac выпускает для своих карт на основе чипов NVIDIA. Для работы утилиты требуется Windows 7 и новее.

Zotac Firestorm использует комбинированную панель для показа и настройки основных параметров:

- частоты процессора;

- частоты, которую использует память;

- температуру, до которой нагрет процессор;

- относительная скорость вращения вентиляторов;

- значение максимального напряжения и т.д.

Пользователь может переключаться между профилями и корректировать настройки. Допускается как автоматическое выставление оптимальных (по мнению Zotac Firestorm) параметров, так и ручная установка предпочитаемых значений. Все изменения применяются в реальном времени, а система мониторинга позволяет сразу отследить эффект.

- Плюсы: удобные настройки и поддержка профилей, рекомендовано NVIDIA.

- Минусы: только для карт производителя.

Проверка результатов разгона

Давайте сравним основные показатели разогнанной видеокарты с показателями без разгона. До разгона

подопытная GeForce GTS 450 демонстрировала следующую продуктивность (см. выше): • PixelFillrate — 6,3 GPixel/s; • TextureFillrate — 25,1 GTexel/s; • пропускная способность памяти (bandwidth) — 57,7 GB/s.

После разгона

были получены следующие результаты (см. скриншот): • PixelFillrate — 7,2 GPixel/s (прирост 14,2%); • TextureFillrate — 28,8 GTexel/s (прирост 14,7%) • пропускная способность памяти (bandwidth) — 66,4 GB/s (прирост 15,0%).

Для проверки прироста продуктивности в условиях, приближенных к реальным, была также использована программа

3DMark11

. Это один из наиболее популярных тестов производительности графических адаптеров. В 3DMark11

без разгона

GeForce GTS 450 показала результат 2272 бала,

после разгона — 2573 бала

. То есть, прирост производительности видеокарты на практике составил

13,2 %

(см. скриншоты).

До разгона

После разгона

Выводы

Теперь вы знаете как разогнать видеокарту Nvidia MSI GTX 1060 (6 Гб). В сегодняшней статье мы провели полноценный пример, как и что делать, а также в какой последовательности. Для разгона мы пользовались утилитой MSI Afrerburner. Результаты замера производительности: до разгона — 4501 очков для всей системы в целом и 4208 очков для видеокарты; после разгона — 4836 очков для системы в целом и 4566 очков для видеокарты. Следовательно, прирост производительности составил +7,4 % для системы в целом и +8,5 % для видеокарты. Если вы нуждаетесь в небольшом приросте производительности, грамотный и осторожный

разгон вашей видеокарты позволит это сделать с минимальными затратами.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Похожие записи:

No related photos.

Оцените статью:

(1 оценок, среднее: 5,00 из 5)

Tweet Pin It

Об авторе

entertainm30

Имею высшее образование в сфере компьютеров. Немного разбираюсь в свободном ПО. Занимаюсь в свободное время ремонтом техники. Являюсь счастливым обладателем 3D принтера. Считаю самообразование очень важным для сегодняшнего времени.

После разгона видеокарты

После разгона

температурный режим работы видеокарты существенно изменяется в сторону повышения, что может сказаться на состоянии охлаждения остальных устройств компьютера. Кроме видеокарты в системном блоке находятся другие «греющиеся» компоненты — центральный процессор, чипсет материнской платы и др. Поэтому после разгона хотя бы на первых порах желательно тщательно отслеживать температуру всех основных устройств компьютера. Например, можно использовать бесплатную программу

SpeedFan. Если температура какого-нибудь устройства компьютера окажется слишком высокой, необходимо позаботиться об улучшении циркуляции воздуха в корпусе системного блока, установив дополнительные кулеры (вентиляторы) на вдув и (или) выдув. Нужно также иметь ввиду, что повышенная температура компьютера или отдельных его устройств может быть вызвана выходом из строя или засорением пылью их системы охлаждения. Порядок устранения указанных проблем описан на нашем сайте в статье о чистке и смазке кулеров.

Характеристики GT 220

Родоначальником карты с индексом 220 является флагман серии – 295-ая модель, от которой карточка, в первую очередь, унаследовала архитектуру графического процессора.

За обработку видео отвечает процессор GT216, построенный на 2 кластерах texture-processing clusters (TPC) и на 8 текстурных блоках (TMU). TPC, в свою очередь, суммарно имеют 48 процессоров потока (по 24 на каждое ядро), а TMU – по 8 блоков на ядро (всего 16). Графические процессоры выполнены по обновленной технологии 40 нм.

Карта оснащена 128-битной шиной памяти, выдающей по 8 операций за такт. В относительных единицах характеристики Nvidia Geforce GT 220 составляют примерно 20% от мощности топовой 295-ой модели. Это компенсируется интегрированной поддержкой современных технологий – DirectX 10.1 и Shader Model 4.1.

Поработали и над звуковой составляющей – устройство поддерживает восьмиканальный звук LPCM, а также встроенные на аппаратном уровне видеокодеки DivX, MPEG-2 и Flash.

Для карточки предусмотрен 1 Gb памяти стандарта DDR3, которая работает по умолчанию на частоте 800 МГц.

Цена Geforce GT 220 по состоянию на август 2022 года колеблется примерно 23-30 USD. Бывшие в употреблении экземпляры оцениваются в 15-20 USD.

Есть с чем сравнить

В своё время (выпущена в 2009 году) эта видеокарта была очень популярна, в первую очередь это связано с низкой ценой. Некоторые называют её дешёвой заглушкой. Но, несмотря на это у GeForce GT 220 есть конкуренты, и они позиционируют себя, как неплохие видеокарты.

Основным конкурентом GT 220 можно назвать Radeon HD 4650, но по частоте ядра 220-тая незначительно выигрывает. Частота шейдеров немного больше чем у конкурента в лице Radeon HD 4650. Но в этой плоскости выигрывает Radeon, имея на борту 320 процессоров к 48-ми потоковых процессоров. В приведённой внизу подробной таблице можно увидеть более подробное сравнение конкурентов GeForce GT 220.

| Максимальное разрешение цифрового монитора | 2560×1600 |

| Максимальное VGA разрешение | 2048×1536 |

| Стандартные разъемы монитора | DVI, VGA, HDMI |

| Поддержка нескольких мониторов | да |

| HDCP | да |

| HDMI | да |

| Аудио вход для HDMI | SPDIF / HDA |

| GeForce 9500 GT | GeForce 9600 GSO | GeForce GT 220 | Radeon HD 4650 | Radeon HD 4670 | |

| Ядро, рабочая частота, МГц | 550 | 550 / 650 | 625 | 600 | 570 |

| Количество отдельных рабочих блоков фильтрации текстур и адресации | 16 | 48 / 32 | 16 | 32 | |

| Количество отдельных блоков ROPs | 8 | 12 / 16 | 8 | 16 | |

| Потоковые процессоры, рабочая частота, МГц | 1400 | 1375 / 1625 | 1360 | 600 | 750 |

| Потоковые процессоры, количество | 32 | 96 / 48 | 48 | 320 | |

| Варианты объема видеопамяти, МБ | 256 / 512 | 384 / 512 | 512 / 1024 | 512 | |

| Варианты типов видеопамяти | DDR2 / DDR3 | DDR3 | DDR2 / DDR3 | DDR2 | DDR3 |

| Рабочая частота памяти, МГц | 800/1600 | 1800 | 800/1580 | 800 | 2000 |

| Ширина шины памяти, бит | 128 | 192 / 256 | 128 | 128 | 128 |

| Поддержка версии DirectX | 10.0 | 10.1 | |||

| Поддержка версии OpenGL | 2.1 | 3.1 | |||

| Поддержка версии PhysX | Есть | Нет | |||

| Наличие аппаратного ускорения видео | Есть | ||||

| Наличие встроенного звукового кодека | Нет | Есть | |||

| Расход энергии, Вт | 50 | 105/90 | 58 | 50 | 60 |

Несмотря на низкую производительность, GeForce 210 может посоревноваться с нынешними аналогами ультрабюджетных видеокарт. Ниша данного видеоадаптера — это компьютер базовой комплектации.

Характеристики

Этот видеочип, сразу стал позиционироваться как бюджетный вариант с низкой ценой, хотя производитель указал, что можно спокойно использовать карту для игровых программ. А если говорить о частоте ядра, у GeForce GT 220 она составляет 625 МГц. Неплохие показатели, если сравнивать с линейкой этой серии. Частота шейдеров равна 1360 МГц, а само их количество составляет 48-штук.

GeForce GT 220 продавалась в двух комплектациях, имевших разный объём видеопамяти: 512МБ или 1024МБ. Тип памяти, который она поддерживает, тоже идёт в двух вариантах: DDR2 на 512МБ версии, и DDR3 на 1ГБ видеоадаптере.

У GeForce GT 220 частота видеопамяти равна 800МГц если это, 512МБ, версия и 1580 для более крутого варианта комплектации. Шина памяти получила свои заслуженные 128-бит. Более подробные характеристики ниже в таблице.

| Наименование | GeForce GT 220 |

| Ядро | GT216 |

| Технический процесс | 40 нм |

| Количество транзисторов | 486 миллионов |

| Рабочая частота ядра | 625 МГц |

| Варианты памяти и ее частота | DDR2 500 (1000)/DDR3 790 (1580)/GDDR3 1012 (2024) |

| Шина памяти | 128-bit |

| ПСП (Гб/с) | 16.0/25.3/32.4 |

| Кол-во отдельных шейдерных блоков | 48 |

| Частота отдельных шейдерных блоков | 1360 |

| TMU на конвейер | 16 |

| ROP | 8 |

| Shaders Model | 4.1 |

| Fill Rate (Mpix/s) | 5000 |

| Fill Rate (Mtex/s) | 10000 |

| Поддерживаемая максимальная версия DirectX | 10.1 |

| Варианты объема памяти | 512/1024 |

| Подключение осуществляется через интерфейс | PCI-E 2.0 |

Какие игры пойдут на Nvidia Geforce GT 220

GT 220 в играх проявляет себя как хорошая карта для среднего уровня (по играм не старше 2011-2012 года).

Для сравнения по списке приведены игры разного уровня со средними настройками графики:

- Нетребовательный уровень (Far Cry 2) – 25 FPS;

- Средний уровень (Devil May Cry 4) – 28 FPS;

- Высокий уровень (Battlefield 3) – 9 FPS.

Очевидно, что комфортная игра может быть только на нетребовательных играх среднего уровня. В целом, карта прекрасно подойдет для таких легендарных игр, как:

- Сетевая легенда — World of Warcraft;

- Civilization IV;

- Sims III;

- Left 4 dead;

- Fallout 3 New Vegas.

Насладиться всеми красотами текстур и графики вряд ли получится на средних настройках названных игр, но гарантирован четкий и комфортный гейминг с минимумом лагов.

Игровые тесты

Но как поведёт себя дешёвая видеокарта, во время игры в шутеры или простые стратегии.

Начнём мы с «Far Cry 2».

- Максимальные настройки – 14 FPS

- Средние – 20 FPS

- Минимальные – 24 FPS

Продолжаем тесты с помощью игры «Devil May Cry 4».

- Максимальные настройки — 23 FPS

- Средние – 28 FPS

- Минимальные – 36 FPS

Из более новых игр мы взяли «Battlefield 3». На максимальных настройках игра попросту не запускалась. В целом результат очень слабый.

- Максимальные настройки — отсутствует

- Средние – 9 FPS

- Минимальные – 13FPS

Новые игры не по зубам GeForce GT 220, но для более стареньких, менее требовательных эта карта подойдёт. Как сообщает nVidia, GT 220 прекрасно подойдёт для следующих игр:

- World of Warcraft;

- Spore;

- Sims3;

- Left 4 Dead;

- Fallout3.

Тесты

Что касаемо тестов, показатели весьма сопоставимы, если учесть цену. Эффективна ли система охлаждения с небольшим, но тихим кулером? Во время продолжительной нагрузки графический чип нагрелся до 72ºC хотя это не критично, но это не лучший показатель. Хотя кулер имеет возможность регулировать свою скорость, это не повлияло на снижение температуры. Скорость вращения лопастей не изменилась со стандартных 35% она увеличилась до 39%.

Информация о программном тестировании приведена ниже:

- Futuremark 3Dmark score – 7860

- Futuremark 3Dmark Vantage – 3370

- PassMark – 178

Сравнивая ультрабюджетники, GeForce GT 220 показывает не плохие результаты.